Förmågan att argumentera, för att uttrycka vår resonemang för andra, är en av de definierande egenskaperna hos vad det är att vara mänsklig.

Argument och debatt utgör hörnstenarna i det civiliserade samhället och det intellektuella livet. Processer av argumentation driver våra regeringar, strukturerar vetenskapliga strävanden och ramar religiös tro. Så borde vi oroa oss för att nya framsteg inom artificiell intelligens tar åtgärder mot att utrusta datorer med dessa färdigheter?

Eftersom tekniken omformar våra liv blir vi alla vana vid nya sätt att arbeta och nya sätt att interagera. Millennials har inte känt något annat. Regeringar och rättsväsende väcker upp till den potential som tekniken erbjuder för att engagera medborgarna i demokratiska och juridiska processer. Vissa politiker är individuellt mer före spelet när de förstår den enorma roll som sociala medier spelar i valprocesser. Men det finns djupa utmaningar.

En är snyggt ställd ut av Upworthy VD Eli Pariser i sitt TED-samtal. I det förklarar han hur vi börjar leva i "filterbubblor": Det du ser när du söker en viss term på Google är inte nödvändigtvis densamma som vad jag ser när jag söker på samma sätt. Medieorganisationer från Fox News till, senast BBC, personifierar innehåll, med ID och inloggning används för att välja vilka historier som presenteras mest framträdande. Resultatet är att vi riskerar att låsa oss in i ekokammare av likasinnade individer medan våra argument blir mer ensidiga, mindre balanserade och mindre förståelse för andra synpunkter.

{youtube}https://youtu.be/4w48Ip-KPRs{/youtube}

TED / YouTube.

Varför kritiskt tänkande är kritiskt

En annan oro är hur nyheter och information, men allt mer voluminösa, blir allt mindre tillförlitliga - anklagelser och motklaganden av "falska nyheter"Är nu vanliga.

I ljuset av sådana utmaningar är kunskaper i kritiskt tänkande viktigare än vad de någonsin varit - förmågan att bedöma och bedöma bevis snabbt och effektivt, att gå utanför vår ekokammare och tänka på saker från alternativa synpunkter, för att integrera information, ofta i team, balanserar argument på båda sidor och når robusta, försvarliga slutsatser. Det här är argumentets färdigheter som har varit föremål för akademisk forskning i filosofi i mer än 2,000 år sedan Aristoteles.

Smakämnen Centrum för Argumentteknik (ARG-tech) vid University of Dundee handlar om att ta och förlänga teorier från filosofi, språkvetenskap och psykologi som berättar om hur människor argumenterar, hur de är oense och hur de når konsensus - och gör dessa teorier till en utgångspunkt för att bygga artificiell intelligens verktyg som modell, känna igen, undervisa och även delta i mänskliga argument.

En av utmaningarna för modern forskning i området har fått tillräckligt med data. AI tekniker som djupt lärande kräver stora mängder data, noga granskade exempel som kan bidra till att bygga robusta algoritmer.

Men att få sådana data är väldigt tufft: det tar högt utbildade analytiker timmar med noggrant arbete att fördärva sättet på vilket argument har sammanställts från bara några minuter av diskurs.

Mer än 10 år sedan vände sig ARG-tech till BBC Radio 4-programmet, Moral Maze, som ett exempel på "guldstandard" -debatt: rigoröst, tätt argument på känslomässiga, aktuella problem, med noggrann och uppmätt moderering. Enormt värdefullt gav dessa data ett program med empiriskt grundad forskning i argumentteknik.

Teknologin

Att arbeta med så krävande data har inneburit att allt från filosofisk teori till storskalig datainfrastruktur har testats. I oktober 2017 körde vi en pilot med BBC Radio Religion & Ethics-avdelningen för att distribuera två typer av ny argumentteknik.

Den första var en uppsättning "analytics". Vi började med att bygga en enorm karta över varje Moral Maze-debatt, bestående av tusentals individuella uttalanden och tusentals fler kopplingar mellan innehållet i alla dessa uttalanden. Varje karta översattes sedan till en serie infographics, med hjälp av algoritmer för att bestämma de mest centrala teman (med något som liknar Googles PageRank algoritm). Vi identifierade automatiskt de mest splittrande frågorna och var deltagarna stod, liksom stunderna i debatten när konflikter nådde kokpunkten, hur väl stödda argument var och så vidare.

Resultatet, vid bbc.arg.tech i samband med Moral Maze presenterar för första gången ett bevisbaserat sätt att förstå vad som verkligen händer i en debatt.

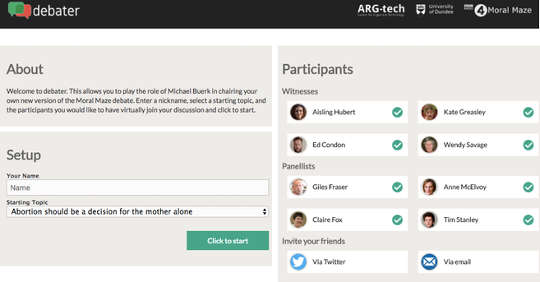

Den andra var ett verktyg som heter "debattör", Som låter dig ta rollen som stolen i Moral Maze och driva din egen version. Det tar argumenten som erbjuds av varje deltagare och låter dig navigera dem, följ din egen näsa för ett bra argument.

Debaterverktyget låter deltagarna ställa en debatt och testa sina färdigheter. BBC / Dundee University ARG-tech

Båda aspekterna syftar till att ge insikt och uppmuntra bättre, mer reflekterande argumentation. Ena sidan tillåter arbetet sammanfattningar av hur man förbättrar kompetens för att argumentera, driven av bevis i data om vad som faktiskt fungerar.

Å andra sidan är möjligheten att uttryckligen lära ut dessa färdigheter: a Testa ditt argument Prototypen som används på BBC Taster-webbplatsen använder exempel från Moral Maze för att utforska ett litet antal argumenteringsförmåga och låter dig gropa dina wits direkt mot maskinen.

Laginsats

I slutändan är målet inte att bygga en maskin som kan slå oss på ett argument. Mycket mer spännande är möjligheten att få AI-programvara att bidra till mänsklig diskussion - erkänna typer av argument, kritisera dem, erbjuda alternativa synpunkter och undersökningsskäl är alla saker som nu är inom räckhåll för AI.

Och det är här att det verkliga värdet ligger - med lag av argumenter, någon människa, en maskin, arbetar tillsammans för att hantera krävande, komplexa situationer från intelligensanalys till företagsledning.

![]() Sådana samarbetsvilliga "mixed-initiative" resonemangsteam ska förändra hur vi tänker på att interagera med AI - och förhoppningsvis omvandla våra kollektiva resonemangsförmåga också.

Sådana samarbetsvilliga "mixed-initiative" resonemangsteam ska förändra hur vi tänker på att interagera med AI - och förhoppningsvis omvandla våra kollektiva resonemangsförmåga också.

Om författaren

Chris Reed, professor i datavetenskap och filosofi, University of Dundee

Den här artikeln publicerades ursprungligen den Avlyssningen. Läs ursprungliga artikeln.

Relaterade böcker:

at InnerSelf Market och Amazon